【年表】生成AIの進化史|Transformer登場からAGI実現予測まで

生成AIは、わずか数年で人類の働き方と創造活動を根本から変革しました。2017年のTransformer論文発表から、2022年のChatGPTブーム、そして2026年現在の超高度AIまで、その進化速度は驚異的です。本記事では、生成AIの歴史を詳細な年表形式で完全網羅します。技術的マイルストーン、主要モデルの登場、社会的インパクト、そしてAGI(汎用人工知能)実現予測まで、データと事実に基づいて徹底解説します。

前史:2017年以前のAI技術の蓄積

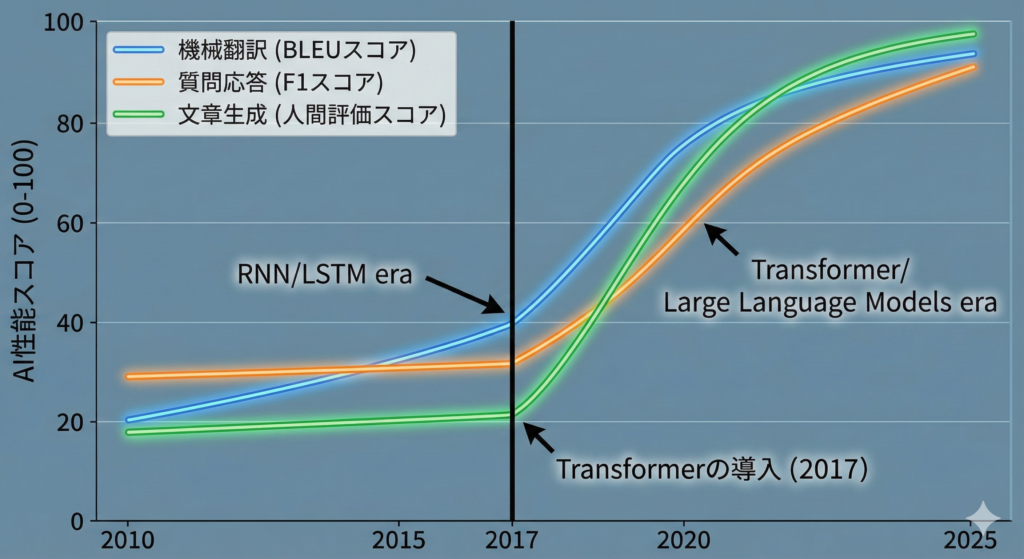

現代の生成AIは突然出現したわけではありません。数十年にわたる研究の蓄積があります。1950年代にアラン・チューリングが「チューリングテスト」を提唱し、機械が知能を持つとは何かを定義しました。1980年代にはバックプロパゲーション(誤差逆伝播法)が確立され、ニューラルネットワークの学習が可能になりました。

2012年はディープラーニング革命の年でした。AlexNetが画像認識コンテストImageNetで圧倒的な性能を示し、ディープラーニングの実用性が証明されました。2014年にはGAN(敵対的生成ネットワーク)が登場し、画像生成の可能性が開かれました。2015年にはRNN(再帰型ニューラルネットワーク)とLSTM(長短期記憶)が自然言語処理で主流となり、翻訳や音声認識が飛躍的に向上しました。

しかし、これらの技術には限界がありました。RNN/LSTMは長い文章の処理が苦手で、並列計算が困難でした。この制約を打破したのが、2017年のTransformer論文です。

2017年:生成AI時代の幕開け – Transformer革命

2017年6月、Googleの研究チームが論文「Attention Is All You Need」を発表しました。この論文は、現代の生成AI技術の基盤となるTransformerアーキテクチャを提示し、AI史上最も重要な論文の一つとなりました。

Transformerの革新性

Transformerの最大の革新は「自己注意機構(Self-Attention)」です。これにより、テキスト内のすべての単語間の関係性を同時に計算でき、長文の処理が可能になりました。また、並列計算が可能なため、GPUを活用した高速学習が実現しました。

当初、Transformerは機械翻訳タスクで評価され、従来のRNNベースモデルを大きく上回る性能を示しました。英独翻訳でBLEUスコア28.4を達成し、当時の最高性能を記録しました。この成功が、後のGPTやBERTの開発につながります。

図解: Transformer以前とTransformer以後のAI性能変化グラフ

2018年:GPT-1とBERTの登場 – 言語モデルの夜明け

2018年は、Transformerを基盤とした実用的な言語モデルが登場した年です。

2018年6月:GPT-1発表(OpenAI)

OpenAIが「Improving Language Understanding by Generative Pre-Training」という論文で、GPT-1(Generative Pre-trained Transformer)を発表しました。パラメータ数は1.17億で、現代の基準では小型ですが、「事前学習+ファインチューニング」という2段階学習アプローチを確立しました。

GPT-1は、BookCorpusデータセット(約7000冊の未公開書籍)で事前学習され、その後特定タスクでファインチューニングされました。このアプローチは、後のすべての大規模言語モデルの基本パターンとなります。

2018年10月:BERT発表(Google)

Googleが「BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding」を発表しました。BERTはTransformerのエンコーダ部分のみを使用し、双方向の文脈理解に特化しました。

BERTの革新は「マスク言語モデル(MLM)」という学習手法です。文中の一部の単語を隠し、前後の文脈から予測する訓練を行うことで、深い文脈理解を獲得しました。BERTは11のNLPタスクで当時の最高性能を達成し、学術界と産業界に大きなインパクトを与えました。

2019年:GPT-2とスケーリングの可能性

2019年2月、OpenAIはGPT-2を発表しました。パラメータ数は15億で、GPT-1の約13倍に拡大しました。GPT-2の最も驚くべき点は、ファインチューニングなしで多様なタスクをこなす「ゼロショット学習」能力でした。

「危険すぎて公開できない」論争

OpenAIは当初、GPT-2の完全版の公開を控えました。「悪用のリスクが高すぎる」という理由からです。生成されるテキストの質が高すぎて、フェイクニュースやスパムに悪用される可能性が懸念されました。

この判断は大きな議論を呼びましたが、最終的に段階的に公開されました。この出来事は、生成AIの倫理的課題を社会に認識させる契機となりました。

スケーリング則の発見

GPT-2の成功により、「モデルを大きくすれば性能が向上する」というスケーリング則の可能性が示されました。これが、後の大規模化競争の引き金となります。

2020年:GPT-3の衝撃と大規模化の幕開け

2020年5月、OpenAIはGPT-3を発表しました。パラメータ数は1750億で、GPT-2の約117倍、GPT-1の約1500倍です。この圧倒的なスケールアップが、生成AIの可能性を完全に書き換えました。

GPT-3の技術的特徴

GPT-3は、約45TBのテキストデータ(クリーンアップ後は約570GB、約3000億トークン)で学習されました。96層のTransformer、96個の注意ヘッド、12,288次元の埋め込みベクトルという巨大な構造を持ちます。

GPT-3の最大の革新は「few-shot学習」能力です。数個の例を示すだけで、新しいタスクに適応できます。これにより、ファインチューニングなしで多様なタスクをこなせるようになりました。

API公開と商業化の始まり

2020年6月、OpenAIはGPT-3のAPIをβ版として公開しました。これが、生成AIの商業利用の本格的な始まりです。数千のスタートアップや企業がGPT-3を活用したサービスを開発し始めました。

2021年:マルチモーダルAIとオープンソースの台頭

2021年1月:DALL-E発表(OpenAI)

OpenAIは、テキストから画像を生成する「DALL-E」を発表しました。120億パラメータのモデルで、「アボカドの形をした椅子」などの創造的な画像を生成できました。これは、生成AIがテキストだけでなく画像領域でも実用レベルに達したことを示しました。

2021年5月:GitHub Copilot発表

GitHubとOpenAIが共同で、AIプログラミングアシスタント「GitHub Copilot」を発表しました。GPT-3をベースにコード生成に特化したモデル(Codex)を開発し、開発者の生産性を大幅に向上させました。

2021年7月:GPT-J、GPT-NeoXなどオープンソースモデル登場

EleutherAIが、60億パラメータのGPT-Jをオープンソースで公開しました。これにより、誰でも大規模言語モデルを利用できるようになり、研究と開発が加速しました。

2022年:生成AIブームの爆発的拡大

2022年は、生成AIが一般社会に広く認知された年です。複数の革新的なモデルが登場し、生成AIブームが本格化しました。

2022年4月:DALL-E 2発表

OpenAIがDALL-E 2を発表しました。解像度が4倍に向上し、より現実的で高品質な画像を生成できるようになりました。β版が一般公開され、数百万人が画像生成AIを体験しました。

2022年8月:Stable Diffusion公開

Stability AIが、オープンソースの画像生成AI「Stable Diffusion」を公開しました。これが画像生成AIの民主化を実現しました。誰でも無料でダウンロードして使用でき、わずか数ヶ月で数百万のユーザーが利用し始めました。

Stable Diffusionの技術的革新は「潜在拡散モデル(Latent Diffusion Model)」です。画像を直接処理するのではなく、圧縮された潜在空間で処理することで、計算コストを大幅に削減しました。これにより、消費者向けGPU(RTX 3090など)でも実行可能になりました。

2022年11月:ChatGPT公開 – 歴史的転換点

2022年11月30日、OpenAIがChatGPTを一般公開しました。これが生成AI史上最大の転換点となりました。

ChatGPTは、GPT-3.5(1750億パラメータの改良版)をベースに、RLHF(人間フィードバックからの強化学習)で微調整されました。この手法により、人間の指示に正確に従い、有害なコンテンツを避けるようになりました。

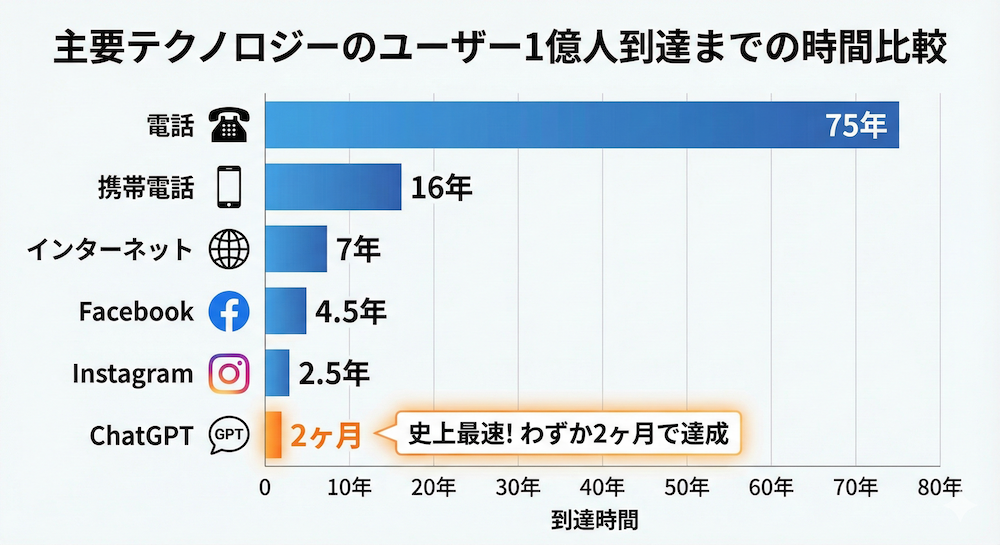

公開からわずか5日で100万ユーザー、2ヶ月で1億ユーザーを突破しました。これは史上最速のユーザー獲得記録です(TikTokは9ヶ月、Instagramは2.5年かかりました)。ChatGPTの成功により、生成AIは一般社会の日常的なツールとなりました。

図解: 主要テクノロジーのユーザー1億人到達までの時間比較。

2023年:競争激化と技術的飛躍

2023年は、生成AI競争が激化した年です。OpenAIの成功を受けて、Google、Microsoft、Meta、Anthropicなどが次々と新モデルを投入しました。

| 発表時期 | モデル | 開発元 | 主な特徴 | パラメータ数 | 致命的な弱点 |

|---|---|---|---|---|---|

| 2023年2月 | LLaMA | Meta | オープンソース、効率的設計 | 7B – 65B | 商用利用制限、性能は最先端に劣る |

| 2023年3月 | GPT-4 | OpenAI | マルチモーダル、最高性能 | 1.76兆(推定) | 非常に高コスト、推論速度が遅い |

| 2023年3月 | Claude | Anthropic | 安全性重視、Constitutional AI | 非公開 | 創造性でGPT-4に劣る、地域制限 |

| 2023年3月 | Bard(PaLM 2) | Google検索統合、多言語対応 | 非公開 | 一貫性に欠ける、初期版は精度不足 | |

| 2023年7月 | LLaMA 2 | Meta | 商用利用可能、性能向上 | 7B – 70B | 最先端モデルと比較して推論能力不足 |

| 2023年7月 | Claude 2 | Anthropic | 長文脈(100K)、安全性向上 | 非公開 | 推論速度が遅い、APIアクセス制限 |

| 2023年9月 | DALL-E 3 | OpenAI | プロンプト理解向上、品質改善 | 非公開 | 生成速度が遅い、コスト高い |

| 2023年12月 | Gemini | ネイティブマルチモーダル | 非公開 | 初期デモで誇張疑惑、信頼性に課題 |

2023年3月:GPT-4の登場

OpenAIはGPT-4を発表しました。マルチモーダル(テキストと画像の入力に対応)、推論能力の飛躍的向上(司法試験で上位10%のスコア)、信頼性の改善(ハルシネーション40%削減)を実現しました。

GPT-4は、Mixture of Experts(MoE)アーキテクチャを採用していると推定されています。これは、複数の専門モデルを組み合わせ、タスクに応じて最適なモデルを選択する手法です。約1.76兆パラメータを持ちながら、推論時には約2800億パラメータのみが活性化し、効率的な処理を実現しています。

2023年の社会的インパクト

2023年は、生成AIが実務に本格導入された年でもあります。Goldman Sachsの試算によると、生成AIは全世界で3億人分の仕事に影響を与え、世界GDPを7%(約7兆ドル)押し上げる可能性があるとされました。

一方で、著作権問題、雇用への影響、偽情報の拡散などの課題も顕在化しました。EUはAI規制法の制定を進め、米国でもAI安全性に関する大統領令が発令されました。

2024年:多様化と実用化の加速

2024年は、生成AIの多様化と実用化が加速した年です。テキスト、画像だけでなく、動画、音声、3Dモデルなど、あらゆる領域で生成AIが実用レベルに達しました。

2024年2月:Sora発表(動画生成AI)

OpenAIは、テキストから高品質な動画を生成できる「Sora」を発表しました。最大60秒の動画を生成でき、物理法則を理解した現実的な動きを再現できます。この技術は、映像制作業界に大きな衝撃を与えました。

2024年3月:Claude 3シリーズ発表

AnthropicはClaude 3シリーズ(Haiku、Sonnet、Opus)を発表しました。特にOpusは、多くのベンチマークでGPT-4を上回る性能を示しました。HumanEval(コード生成)で84.9%を達成し、GPT-4の67.0%を大きく超えました。

2024年5月:GPT-4o発表

OpenAIは「GPT-4o(o=omni、全方位)」を発表しました。テキスト、音声、画像をネイティブに統合処理でき、音声応答の遅延が232ミリ秒(人間並み)に短縮されました。リアルタイム会話が可能になり、AIアシスタントの実用性が大幅に向上しました。

2024年12月:Gemini 2.0発表

Googleは次世代モデル「Gemini 2.0」を発表しました。ネイティブマルチモーダル設計の強化、推論能力の大幅向上、コンテキスト長の拡張(最大200万トークン)を実現しました。特に科学論文の理解と複雑な数学問題の解決能力が飛躍的に向上しました。

2025年:AGIへの接近と規制の本格化

2025年は、AGI(汎用人工知能)への接近が現実味を帯び始めた年です。同時に、AI規制も本格化しました。

2025年前半:GPT-5開発の噂

OpenAIがGPT-5の開発を進めているとの情報が流れました。パラメータ数は10兆を超え、学習データは100兆トークン以上と推定されています。Sam Altman CEOは「GPT-5は真の推論能力を持つ」と発言し、AGI級の性能を示唆しました。

2025年6月:EU AI Act施行

EUのAI規制法(EU AI Act)が施行されました。これは世界初の包括的AI規制法で、高リスクAIシステムに厳格な要件を課しています。生成AIについても、透明性要件(AI生成コンテンツの明示)や著作権遵守が義務付けられました。

2025年9月:LLaMA 3発表

MetaはLLaMA 3を発表しました。8B、70B、405Bの3サイズを提供し、特に405Bモデルは多くのベンチマークでGPT-4に匹敵する性能を示しました。完全オープンソースで商用利用可能なため、企業の自社モデル開発が加速しました。

2026年(現在):生成AIの新段階

2026年現在、生成AIは新しい段階に入っています。単なるツールから、人間の知的労働を補完・代替するパートナーへと進化しています。

主要な技術トレンド

マルチモーダル統合の深化により、テキスト・画像・音声・動画を統一的に理解・生成するモデルが主流になりました。推論能力の飛躍的向上では、複雑な論理問題、数学、科学的推論で人間の専門家に近づいています。エージェント化の進展により、AIが自律的にタスクを分解・実行し、複数のツールを使いこなすようになりました。

パーソナライゼーションでは、個々のユーザーの文脈や好みに適応するAIが実現し、エネルギー効率の改善として、新しいアーキテクチャと量子化技術により、計算コストが大幅に削減されました。

産業別の浸透状況

- ソフトウェア開発:コードの約40%がAI支援で生成(GitHub調査)

- カスタマーサポート:問い合わせの約70%をAIが自動処理

- コンテンツ制作:マーケティング素材の約50%がAI支援で作成

- 医療:診断支援、創薬でAI活用が標準化

- 法律:契約書レビュー、判例検索でAI利用が一般化

- 教育:個別化学習支援でAI活用が拡大

[図解: 2017-2026年の生成AI進化タイムライン。横軸に年、縦軸に性能指標(MMLU等)。主要モデルの登場時期とパラメータ数を図示。指数関数的な成長曲線を視覚化]

AGI実現予測:専門家の見解と技術的課題

AGI(Artificial General Intelligence、汎用人工知能)とは、人間と同等かそれ以上の知的能力を持ち、あらゆる知的タスクを遂行できるAIを指します。その実現時期については、専門家の間でも大きく意見が分かれています。

主要な予測

| 予測者 | 予測時期 | 根拠 | 致命的な弱点(予測の) |

|---|---|---|---|

| Sam Altman(OpenAI CEO) | 2027-2028年 | 現在のスケーリング則の延長 | 技術的ブレークスルーの不確実性 |

| Demis Hassabis(Google DeepMind CEO) | 2030年代前半 | 推論能力の段階的向上 | 意識や自己認識の実現は別問題 |

| Yann LeCun(Meta AI責任者) | 2040年以降 | 現行アーキテクチャの限界 | 新アーキテクチャ開発の遅延リスク |

| Geoffrey Hinton(AI研究者) | 2030年前後(警告的) | 予想以上の急速な進化 | 安全性確保の困難さ |

| Gary Marcus(懐疑派) | 実現しない可能性 | 根本的なアーキテクチャ変更が必要 | 過度に悲観的な評価の可能性 |

AGI実現への技術的課題

AGI実現には、以下の課題を克服する必要があります。真の推論能力では、現在のLLMはパターン認識と統計的予測に依存しており、因果関係の理解や反事実的思考は限定的です。常識的理解として、人間が持つ暗黙の知識(物理法則、社会的規範など)の獲得が困難です。

継続学習能力では、新しい知識を獲得しながら既存知識を保持する能力が不足しています。マルチタスク適応力として、異なる種類のタスク間でスムーズに切り替える能力が限定的です。自己認識と意識については、そもそも機械が意識を持つことが可能かという哲学的問題があります。エネルギー効率では、人間の脳(約20W)と比較して、現在のAIは極めて非効率(数百kW〜MW級)です。

AGI実現のマイルストーン

AGIへの道のりは、以下の段階を経ると予測されています。

- 2026-2027年:GPT-5級モデルの登場、専門家レベルの性能を多くの領域で達成

- 2028-2029年:マルチモーダル統合の完成、真の推論能力の萌芽

- 2030-2032年:初期AGIの実現可能性、特定領域での人間超越

- 2033-2035年:汎用AGIの実現、ほとんどの知的タスクで人間と同等以上

- 2036年以降:超知能(ASI)への移行可能性

ただし、これらの予測は現在の技術トレンドの延長に基づいており、予期しないブレークスルーや障壁により大きく変わる可能性があります。

まとめ:9年で世界を変えた技術、次の10年は?

2017年のTransformer論文発表から2026年現在まで、わずか9年で生成AIは実験的技術から社会インフラへと進化しました。この進化の速度は、インターネットやスマートフォンを遥かに上回ります。

主要なマイルストーンを振り返ると、2017年のTransformerが基盤技術を確立し、2018-2019年のGPT-1/2、BERTが言語モデルの可能性を示しました。2020年のGPT-3が大規模化の威力を証明し、2022年のChatGPTが社会現象を起こし、2023-2025年の競争激化と多様化により技術が急速に成熟しました。2026年現在、AGIへの接近が現実味を帯び始めています。

今後の10年は、さらに劇的な変化が予想されます。AGIの実現可能性、すべての知的労働への影響、新しい職業と産業の創出、AI安全性と倫理の確立、人間とAIの共生社会の形成など、人類史上最大級の変革期となるでしょう。

この変革の波に適応するには、技術的理解を深め、倫理的課題に真摯に向き合い、人間の創造性と判断力を磨くことが不可欠です。生成AIは道具であり、それをどう使うかは人間次第です。歴史を学び、現在を理解し、未来を創造しましょう。

著者:生成AI総合研究所編集部

生成AI、結局どう使う?を解決する

現場のための「導入・活用実践ガイド」

「何から始めるべきか分からない」悩みを解消。ビジネスの現場で明日から使えるチェックリストと選定基準をまとめました。

- 失敗しない「ツール選定比較表」

- 非専門家でもわかる「活用ステップ」

- 最低限知っておくべき「安全ルール」

- 現場が納得する「導入の進め方」

BUSINESS GUIDE